لوحة المتصدرين

المحتوى الأكثر حصولًا على سمعة جيدة

المحتوى الأعلى تقييمًا في 06/12/21 في كل الموقع

-

لماذا تريد عمل validation للموقع ؟ , بما أنك تقوم بأخذ lat, long يمكنك التأكد من أن الحقلين الذين تضع بهما lat, long غير فارغين , إذا أردت التأكد من أن lat, long صحيحين يمكنك استخدام حزمة geolocator بحيث عندما تقوم بتمرير lat, long إلى دالة LatLng بحيث تتأكد أنها ترجع position ولا لا , صراحة اول مرة أواجه مثل هذا الأمر بأن أقوم بعمل validation للموقع . setState((){ currentPosition = LatLng(lat, long); });2 نقاط

-

هذا يعتمد على البيانات التي تجلبها كموقع، يمكنك تخزين الإحداثيات x,y في متغيرين مثلا وتسند لهما القيمة المعادة من marker في الصفحة الأخرى، أو جلب اسم المنطقة/العنوان كامل كنص و تخزينه. التحقق،بالنسبة للنص: النص غير فارغ. وبالنسبة للموقع كإحداثيات: درجات الطول تتراوح بين -90 و 90. أما درجات العرض بين -180 و 180.2 نقاط

-

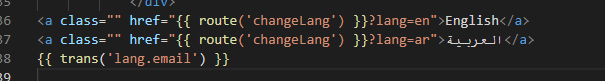

الدالة translate تجلب قيمة النص الموافقة للمفتاح الممرر، وإن لم تجده ينتج استثناء (خطأ) يمكنك إرفاق الشيفرة للتأكد من المشكلة، وعليك أن توضح الخطأ، يصعب علينا فهم سبب المشكلة بالضبط بدون أي دليل2 نقاط

-

لدي جدول لتخزين رسائل الدردشه وبه عمود للاي دي وعمود لتخزين اي دي مرسل الرسالة وعمود لتخزين نص الرساله وعمود لتخزين تاريخ الارسال، استطيع عمل الاستعلام وعرض الرسائل للمستخدم، ولكن يصعب علي تمييز أية رسائل قرءها المستخدم وأي منها جديدة لم يقرءها، ماهي الطريقه او الفكره لمعرفة الرسائل الجديده، من اجل اشعار المستخدم بها، للعلم ان هذه دردشة عامه وليست خاسه التي يسهل تمييز الرسائل الجديده بإضافة عمود نخزن به ١ اذا كانت جديده و٠ عند قراءتها وسكرا1 نقطة

-

الطريقة المستعملة في تحديث جزء من الصفحة دون تحديث الصفحة كاملة هي ما يسمى ب ajax requests calls يمكن الحصول على معلومات من الخادم دون الحاج إلى تحديث الكامل لصفحة بواسطة javascript عن طريق المكون XMLHttpRequest // XMLHttpRequest إنشائ الكائن var xhttp = new XMLHttpRequest(); // XMLHttpRequest تحدد خاصية وظيفة يتم تنفيذها في كل مرة تتغير فيها حالة كائن onreadystatechange : xhttp.onreadystatechange = function() { // هي 200 readyState عندما تكون الخاصية هي 4 وخاصية status ، تكون الاستجابة جاهزة if (this.readyState == 4 && this.status == 200) { // تقوم الخاصية responseText بإرجاع استجابة الخادم كسلسلة نصية. // يمكن استخدام السلسلة النصية لتحديث صفحة الويب: document.getElementById("demo").innerHTML = xhttp.responseText; } }; // data.php سيتم الحصول على المعلمات من ملف xhttp.open("GET", "data.php", true); // إنهاء الإتصال xhttp.send() يمكنك قراءة المزيد حول XMLHttpRequest من هنا1 نقطة

-

في الوقت الحالي أنا أتعلم كيفية استخدام الـ threading و multiprocessing في بايثون لتشغيل عمليات معينة بالتوازي وتسريع الكود الخاص بي. لكن لدي مشكلة في معرفة الفرق بين هذه المكتبات، ما الفرق بين الكائنين التاليين؟ threading.Thread() multiprocessing.Process() متى أستعمل كلًا من مكتبة threading أو multiprocessing؟1 نقطة

-

يمكنك حفظ ID آخر رسالة مقروءة ضمن ملفات Cookies في متصفح المستخدم. وعند جلب رسائل جديدة، أي رسالة لها معرف ID أكبر هي جديدة.. ثم قم بإسناد آخر ID لل Cookies كتحديث (بعد كل رسالة جديدة).1 نقطة

-

هي طريقه تكافئ طريقة KMeans الفرق الوحيد هو أنه يتم تقسيم الداتا إلى أجزاء ومن ثم تطبيق KMeans لتسريع العملية. يتم استخداه عبر الموديول cluster.MiniBatchKMeans #استدعاء المكتبات from sklearn.cluster import MiniBatchKMeans في البداية قمنا باستدعاء المكتبة التي يوجد فيها هذا الموديل #الشكل العام للموديل MiniBatchKMeansModel=MiniBatchKMeans(n_clusters=8,init='k-means++',batch_size=100, compute_labels=True,random_state=None, max_no_improvement=10) البارمتر الأول n_clusters وهو عدد العناقيد المراد تكوينها البارمتر الثاني init مصفوفه ابعادها عدد الفيتشرز ضرب عدد العناقيد ولتهيئتها يوجد طريقتين الأولى random يتم اختيار مراكز العناقيد الأوليه بشكل عشوائي من الصفوف في الداتا و k-means++ يتم اختيار المراكز الأوليه بطريقه ذكيه لتسريع التقارب البارمتر الثالثbatch_size وهو يمثل حجم كل جزء مقسم البارمتر الرابع compute_labels عند إعطاءه القيمه True يقوم بحساب عدد العناقيد بمجرد أن يصل أحد الأجزاء إلى التقارب البارمتر الخامس random_state للتحكم بآلية التقسيم البارمتر السادس max_no_improvement تحديد العدد الأعظمى لعدد الأجزاء المتتاليه التي لا تحسن في التقارب عن طريق التوقف المبكر عند وضعها None تتعطل هذه المهمه طبعا قمت بشرح الشكل العام للموديل ولكن عن طريقة استخدامه سهل جدا فقط بعد أن تقوم بتقسيم الداتا إلى X_train,X_test تسطيع كتابة الأتي لعملية التدريب #الشكل العام للموديل: MiniBatchKMeansModel = MiniBatchKMeans(n_clusters=8, init='k-means++', batch_size=100,compute_labels=True, random_state=None,max_no_improvement=10) MiniBatchKMeansModel.fit(X_train) حيث الدالة fit يوجد ضمنها جميع العمليات الداخلية لعملية التدريب يوجد دالة أخرى تستخدم لغرض التنبؤ كالاتي #حساب القيم المتوقعة: y_pred = MiniBatchKMeansModel.predict(X_test) حيث قمنا بحساب كل سطر من داتا الاختبار لأي عنقود يتبع نستطيع حساب دقة الموديل أو كفاءته على التدريب والاختبار عن طريق التابع score ويكون وفق الشكل #طباعة الكفاءه على التدريب والاختبار ومراكز العناقيد print('Train Score is : ' , MiniBatchKMeansModel.score(X_train)) print('Test Score is : ' , MiniBatchKMeansModel.score(X_test)) print('centers are : ' , MiniBatchKMeansModel.cluster_centers_)1 نقطة

-

لزيادة الفائدة أود إلقاء مراجعة صغيرة على هذه الخوارزمية قبل أن أعرض لك كيفية تطبيقها: K-Means طريقة لعمل تقسيم للبيانات الغير معنونة أي unlabeled data يتم أولاً تحديد عدد المجموعات المطلوب Clusters تقوم الخوارزمية بتحديد عدد من النقاط العشوائية وسط النقاط تسمي cluster centroid ويكون عددها هو نفس عدد المجموعات المطلوب ثم يقوم بتقسيم نقاط العينة عبر المراكز يقوم بعمل تغيير في اماكن المراكز , و يعيد الخطوة , حتي يصل للشكل الأمثل وهو يستخدم في التعلم بلا إشراف. في Sklearn يتم استخدامها عبر الموديول cluster.KMeans. #استدعاء المكتبة from sklearn.cluster import KMeans في البداية قمنا باستدعاء المكتبة التي يوجد فيها هذا الموديل #الشكل العام للموديل sklearn.cluster.KMeans(n_clusters=8, init='k-means++', n_init=10, random_state=None, copy_x=True, n_jobs=None, algorithm='auto’) البارمتر الأول n_clusters وهو عدد العناقيد المراد تكوينها البارمتر الثاني init مصفوفه ابعادها عدد الفيتشرز ضرب عدد العناقيد ولتهيئتها يوجد طريقتين الأولى random يتم اختيار مراكز العناقيد الأوليه بشكل عشوائي من الصفوف في الداتا و k-means++ يتم اختيار المراكز الأوليه بطريقه ذكيه لتسريع التقارب البامتر الثالث n_init عدد المرات التي ستعمل فيها الخوارزميه مع مراكز عناقيد مختلفه البارمتر الرابع random_state للتحكم بآلية التقسيم البارمتر الخامس copy_x في حال ضبطه على True سوف يأخذ نسخة من البيانات ولن يتم التعديل عليها أي أن البيانات تعود كما أخذت أما في حال false سوف يتم التعديل على البيانات الاصليه البارمتر السادس n_jobs عدد المعالجات التي تعمل بالتوازي وبتالي كلما زاد العدد زاد التسريع ,يوضع -1 للدلاله على عمل كامل المعالجات البارمتر السابع algorithm الخوارزميه التي تستخدمها kmean ويفضل وضع auto لترك kmeans تقرر المناسب لها طبعا قمت بشرح الشكل العام للموديل ولكن عن طريقة استخدامه سهل جدا فقط بعد أن تقوم بتقسيم الداتا إلى X_train,X_test تسطيع كتابة الأتي لعملية التدريب #الشكل العام للموديل KMeansM=KMeans(n_clusters=8, init='k-means++', n_init=10, random_state=None, copy_x=True, n_jobs=None, algorithm='auto’) KMeansM.fit(X_train) حيث الدالة fit يوجد ضمنها جميع العمليات الداخلية لعملية التدريب يوجد دالة أخرى تستخدم لغرض التنبؤ كالاتي #حساب القيم المتوقعة y_pred = KMeansModel.predict(X_test) حيث قمنا بحساب كل سطر من داتا الاختبار لأي عنقود يتبع نستطيع حساب دقة الموديل أو كفاءته على التدريب والاختبار عن طريق التابع score ويكون وفق الشكل #طباعة الكفاءه على التدريب والاختبار ومراكز العناقيد print('Train Score is : ' , KMeansM.score(X_train)) print('Test Score is : ' , KMeansM.score(X_test)) print('centers are : ' , KMeansM.cluster_centers_) #استدعاء المكتبات from sklearn.cluster import KMeans #الشكل العام للموديل KMeansM=sklearn.cluster.KMeans(n_clusters=8, init='k-means++', n_init=10, random_state=None, copy_x=True, n_jobs=None, algorithm='auto’) KMeansM.fit(X_train) #طباعة الكفاءه على التدريب والاختبار ومراكز العناقيد print('Train Score is : ' , KMeansM.score(X_train)) print('Test Score is : ' , KMeansM.score(X_test)) print('centers are : ' , KMeansM.cluster_centers_) #حساب القيم المتوقعه y_pred = KMeansModel.predict(X_test)1 نقطة

-

المواصفات: وحدة المعالجة المركزية : Intel Core i5 – i7 من الجيل العاشر. بطاقة رسومات Intel Iris Plus – Nvidia GeForce GTX 1650 Ti. ذاكرة الوصول العشوائي: 8 جيجابايت – 64 جيجابايت. الشاشة: 15.6 بوصة FHD + (1920 × 1200) IPS – UHD + (3840 × 2400). التخزين: 256 جيجا بايت – 1 تيرا بايت SSD.1 نقطة

-

1 نقطة

-

يمكنك استخدامها عبر الموديول ensemble.RandomForestRegressor الصيغة العامة: sklearn.ensemble.RandomForestRegressor(n_estimators=100, criterion='mse', max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features='auto', bootstrap=True, oob_score=False, n_jobs=None, random_state=None, verbose=0 ccp_alpha=0.0, max_samples=None) n_estimators : عدد أشجار القرار المستخدمة. max_depth : عمق الأشجار. min_samples_split: الحد الادني من التقسيمات المسموح بها. n_jobs: عدد المهام التي يتم تنفيذها بالتوازي. -1 للتنفيذ بأقصى سرعة ممكنة. random_state: يتحكم بعملية التقسيم افتراضياً يكون None. ccp_alpha: معامل تعقيد يستخدم لتقليل التكلفة الزمانية والمكانية. non-negative float, default=0.0 criterion: الأسلوب الرياضي للمعالجة وتكون {“mse”, “friedman_mse”, “mae”, “poisson”}, "default=”mse min_samples_split:الحد الأدنى لعدد العينات المطلوبة لتقسيم عقدة داخلية. int , default=2. min_samples_leaf: الحد الأدنى لعدد العينات المطلوبة في العقدة التي تمثل الاوراق. default=1. verbose: لعرض التفاصيل التي تحدث في التدريب. افاراضياً 0 أي لايظهر شيء، أما وضع أي قيمة أكبر من الصفر سيعرض التفاصيل int. bootstrap: لتحديد فيما إذا كان سيتم استخدام عينات ال bootstrap عند بناء الأشجار. في حال ضبطها على true سيتم استخدام كامل البيانات لبناء كل شجرة. افتراضياً تكون False. oob_score: لتحديد فيما إذا كان سيتم استخدام عينات out-of-bag لتقدير قيمة التعميم "generalization score". ويجب أن تكون bootstrap مضبوطة على True لاستخدامها. max_features:العدد المناسب من الفيتشرز التي يتم احتسابها {“auto”, “sqrt”, “log2”}. في حال auto: max_features=sqrt(n_features). sqrt: ax_features=sqrt(n_features). log2: max_features=log2(n_features). None: max_features=n_features. إذا وضعت قيمة float: max_features=int(max_features * n_features) قيمة int: سيتم أخذ ال features عند كل تقسيمة ك max_features. التوابع: fit(data): للقيام بعملية التدريب. predict(data): لتوقع القيم. score(data): لتقييم كفاءة النموذج. ()get_params :لايجاد مقدار الدقة predict_proba(data) : لعمل التوقع أيضاً لكن هنا سيخرج الفيمة الاحتمالية(أي لن يتم القصر على عتبة) apply(data): ياتي لك بقيمة الورقة المحسوبة. ()get_n_leaves: يرد عدد الأوراق. ()get_depth: يرد عمق الشجرة. ال attributtes: classes_: لعرض ال labels التي وجدها. feature_importances_: عرض أهم الفيتشرز المؤثرة في التوقع. مثال: from sklearn.datasets import load_boston from sklearn.model_selection import train_test_split from sklearn.ensemble import RandomForestRegressor # تحميل الداتا BostonData = load_boston() data = BostonData.data labels = BostonData.target # تقسيم البيانات X_train, X_test, y_train, y_test = train_test_split(data, labels, test_size=0.2, shuffle =True, random_state=2021) # DecisionTreeRegressor تطبيق RandomForestR = RandomForestRegressor(n_estimators=100, random_state=44) RandomForestR.fit(X_train, y_train) #Calculating Details print('Train Score is : ' , RandomForestR.score(X_train, y_train)) print('Test Score is : ' , RandomForestR.score(X_test, y_test)) # 0.7831947504479144 print('No. of features are : ' , RandomForestR.n_features_)1 نقطة

-

يمكنك القيام بذلك عن طريق الموديول tree أن تستدعي الكلاس DecisionTreeRegressor: sklearn.tree.DecisionTreeRegressor الصيغة العامة: sklearn.tree.DecisionTreeRegressor( criterion='mse', splitter='best', max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features=None, random_state=None, max_leaf_nodes=None, ccp_alpha=0.0) الوسطاء نفسها في حالة التصنيف مع بعض الاختلافات في القيم: criterion: الأسلوب الرياضي للمعالجة وتكون {“mse”, “friedman_mse”, “mae”, “poisson”}, "default=”mse splitter: الاستراتيجية المستخدمة لاختيار الانقسام عند كل عقدة. {“best”, “random”}, "default=”best random ليكون التقسيم عشوائي و best لاختيار أفضل تقسيم. min_samples_split:الحد الأدنى لعدد العينات المطلوبة لتقسيم عقدة داخلية. int , default=2. min_samples_leaf: الحد الأدنى لعدد العينات المطلوبة في العقدة التي تمثل الاوراق. default=1 n_jobs: عدد المهام التي يتم تنفيذها بالتوازي نضع -1 للتنفيذ على ال GPU. max_depth: عمق شجرة القرار. default=None min_samples_split:الحد الادني من التقسيمات المسموح بها tol: (مقدار السماحية) عدد يمثل نقطة إيقاف التعلم بحال تجاوز هذه القيمه فيتوقف ال optimizer . max_features:العدد المناسب من الفيتشرز التي يتم احتسابها {“auto”, “sqrt”, “log2”}. في حال auto: max_features=sqrt(n_features). sqrt: ax_features=sqrt(n_features). log2: max_features=log2(n_features). None: max_features=n_features. إذا وضعت قيمة float: max_features=int(max_features * n_features) قيمة int: سيتم أخذ ال features عند كل تقسيمة ك max_features. random_state: يتحكم بعملية التقسيم افتراضياً يكون None. ccp_alpha: معامل تعقيد يستخدم لتقليل التكلفة الزمانية والمكانية. non-negative float, default=0.0 التوابع: fit(data): للقيام بعملية التدريب. predict(data): لتوقع القيم. score(data): لتقييم كفاءة النموذج. ()get_params :لايجاد مقدار الدقة predict_proba(data) : لعمل التوقع أيضاً لكن هنا سيخرج الفيمة الاحتمالية(أي لن يتم القصر على عتبة) apply(data): ياتي لك بقيمة الورقة المحسوبة. ()get_n_leaves: يرد عدد الأوراق. ()get_depth: يرد عمق الشجرة. ال attributtes: classes_: لعرض ال labels التي وجدها. feature_importances_: عرض أهم الفيتشرز المؤثرة في التوقع. مثال: # بيانات أسعار المنازل في مدينة بوسطن from sklearn.datasets import load_boston from sklearn.model_selection import train_test_split from sklearn.tree import DecisionTreeRegressor # تحميل الداتا BostonData = load_boston() data = BostonData.data labels = BostonData.target # تقسيم البيانات X_train, X_test, y_train, y_test = train_test_split(data, labels, test_size=0.2, shuffle =True, random_state=2021) # DecisionTreeRegressor تطبيق DecisionTreeR = DecisionTreeRegressor(random_state=20) DecisionTreeR.fit(X_train, y_train) #حساب الدقة print('Train Score is : ' , DecisionTreeR.score(X_train, y_train)) print('Test Score is : ' , DecisionTreeR.score(X_test, y_test)) #حعرض التوقعات y_pred = DecisionTreeR.predict(X_test) print(y_pred)1 نقطة

-

1 نقطة

-

يمكنك القيام بذلك عن طريق الموديول tree أن تستدعي الكلاس DecisionTreeClassifier: tree.DecisionTreeClassifier الصيغة العامة: sklearn.tree.DecisionTreeClassifier(criterion='gini', splitter='best', max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features=None, random_state=None, max_leaf_nodes=None, min_impurity_decrease=0.0, min_impurity_split=None, ccp_alpha=0.0 الوسطاء: splitter: الاستراتيجية المستخدمة لاختيار الانقسام عند كل عقدة. {“best”, “random”}, "default=”best random ليكون التقسيم عشوائي و best لاختيار أفضل تقسيم. min_samples_split:الحد الأدنى لعدد العينات المطلوبة لتقسيم عقدة داخلية. int , default=2. min_samples_leaf: الحد الأدنى لعدد العينات المطلوبة في العقدة التي تمثل الاوراق. default=1 n_jobs: عدد المهام التي يتم تنفيذها بالتوازي نضع -1 للتنفيذ على ال GPU. max_depth: عمق شجرة القرار. default=None min_samples_split:الحد الادني من التقسيمات المسموح بها tol: (مقدار السماحية) عدد يمثل نقطة إيقاف التعلم بحال تجاوز هذه القيمه فيتوقف ال optimizer . max_features:العدد المناسب من الفيتشرز التي يتم احتسابها {“auto”, “sqrt”, “log2”}. في حال auto: max_features=sqrt(n_features). sqrt: ax_features=sqrt(n_features). log2: max_features=log2(n_features). None: max_features=n_features. إذا وضعت قيمة float: max_features=int(max_features * n_features) قيمة int: سيتم أخذ ال features عند كل تقسيمة ك max_features. random_state: يتحكم بعملية التقسيم افتراضياً يكون None. ccp_alpha: معامل تعقيد يستخدم لتقليل التكلفة الزمانية والمكانية. non-negative float, default=0.0 criterion: الأسلوب الرياضي للمعالجة وتكون gini , entropy min_impurity_split: عتبة التوقف المبكر لنمو الشجرة.float, default=0 التوابع: fit(data): للقيام بعملية التدريب. predict(data): لتوقع القيم. score(data): لتقييم كفاءة النموذج. ()get_params :لايجاد مقدار الدقة predict_proba(data) : لعمل التوقع أيضاً لكن هنا سيخرج الفيمة الاحتمالية(أي لن يتم القصر على عتبة) apply(data): ياتي لك بقيمة الورقة المحسوبة. ال attributtes: classes_: لعرض ال labels التي وجدها. feature_importances_: عرض أهم الفيتشرز المؤثرة في التوقع. # استيراد المكتبات from sklearn.datasets import load_breast_cancer from sklearn.model_selection import train_test_split from sklearn.tree import DecisionTreeClassifier from sklearn.metrics import confusion_matrix import seaborn as sns import matplotlib.pyplot as plt #تحميل البيانات data = load_breast_cancer().data labels = load_breast_cancer().target # تقسيم البيانات X_train, X_test, y_train, y_test = train_test_split(data, labels, test_size=0.2, random_state=2021, shuffle =True) DecisionTreeC = DecisionTreeClassifier(criterion='gini',max_depth=3,random_state=2021) DecisionTreeC.fit(X_train, y_train) # حساب التوقع print('Train Score is : ' , DecisionTreeC.score(X_train, y_train)) print('Test Score is : ' , DecisionTreeC.score(X_test, y_test)) # 0.9473684210526315 # عرض الفئات الموجودة print('Classes are : ' , DecisionTreeC.classes_) # Classes are : [0 1] #عرض أهم الفيتشرز التي تؤثر في عملية التوقع print('feature importances are : ' , DecisionTreeC.feature_importances_) #حساب التوقع y_pred = DecisionTreeC.predict(X_test) # حساب التوقع كقيماحتمالية y_pred_prob = DecisionTreeC.predict_proba(X_test)1 نقطة

-

يمكنك القيام بذلك عن طريق الكلاس SVC من الموديول SVM. أي يمكنك استخدامها عبر الموديول svm.SVC C-Support Vector Classification الصيغة العامة: class sklearn.svm.SVC(C=1.0, kernel='rbf', degree=3, coef0=0.0, shrinking=True, probability=False, tol=0.001, cache_size=200, class_weight=None, verbose=False, max_iter=- 1, decision_function_shape='ovr', gamma='scale', break_ties=False, random_state=None) الوسطاء: يوجد عدة أنواع ‘linear’, ‘poly’, ‘rbf’, ‘sigmoid’, ‘precomputed’ ننصح دوما باستخدام rbf لأنها الأفضل. degree: وهو في حال أردنا جعل ال regressor غير خطي أي Polynomial نضبطه بالدرجة التي نريدها(default=3). بحال استخدام الkernel=poly فيجب تحديد درجة كثير الحدود. tol: عدد يمثل نقطة إيقاف التعلم بحال تجاوز هذه القيمه فيتوقف svr. kernel: النواة أو المعادلة المستخدمة تكافئ فكرة تابع التنشيط في الشبكات العصبونية. C: معامل التنعيم أفضل القيم للتجريب 0.1,0.001,10,1 max_iter: العدد الأقصى للتكرارت إذا وضعت -1 فأنه يأخذ الحد الأعلى ويفضل ذلك epsilon: ضمن هذا المقدار لن يتم تطبيق أي penalty على تابع التكلفة. أي هي هامش للسماحية بدون تطبيق penalty. افتراضياً default=0.1. cache_size: تحديد حجم ال kernel cache وافتراضياً 200 MB. gamma: معمل النواة وهي إما {‘scale’, ‘auto’}أو float وتكون افتراضياً 'default=’scale. coef0: مصطلح مستقل يتعلق بدالة النواة ويعمل فقط في حالة كانت الدالة هي sigmoid و poly. shrinking: لتحديد فيما إذا كنت تريد استخدام shrinking heuristic أو لا. decision_function_shape: إما ova أو ovo وافتراضياً 'default='ovr وهي تمثل شكل تابع القرار الذي سيتم إرجاعه one-vs-rest أو one-vs-one. ال attributes: intercept_ : التقاطع مع المحور الاحداثي أي الثوابت في معادلة الفرضية. coef_: أوزان التدريب. التوابع: (data,labels)fit: للقيام بعملية التدريب. (y-true,y_pred)score: لتقييم دقة النموذج. (data)predict: للتوقع. مثال على بيانات breast cancer وهي بيانات لأمراض سرطان الثدي. from sklearn.metrics import confusion_matrix import seaborn import matplotlib from sklearn.datasets import load_breast_cancer from sklearn.model_selection import train_test_split from sklearn.svm import SVC # تحميل الداتا data = load_breast_cancer().data labels = load_breast_cancer().target # تقسيم البيانات X_train, X_test, y_train, y_test = train_test_split(data, labels, test_size=0.2, random_state=2021, shuffle =True) # SVC تطبيق ال SVCM = SVC(kernel= 'rbf', max_iter=100, C=1.0, gamma='auto') SVCM.fit(X_train, y_train) # عرض الدقة print('Train Score is : ' , SVCM.score(X_train, y_train)) print('Test Score is : ' , SVCM.score(X_test, y_test)) # 0.8859649122807017 # لعرض القيم المتوقعة y_pred = SVCM.predict(X_test) # حساب مصفوفة التشتت c = confusion_matrix(y_test, y_pred) print('Confusion Matrix is : \n', c) # الرسم seaborn.heatmap(c, center = True) matplotlib.pyplot.show()1 نقطة

-

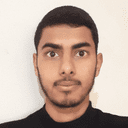

السلام عليكم أنا لا أريد تعلم ماذكرت في عنوان السؤال من الصفر أنا عندي خلفية في كثير من الامور، ولكن الذي اريده هو، كيف أجعل هذه الواجهه متطوره، يعني من البديهي في الويب إن محاذات العناصر في الحاويات تكون من الأعلى إلى الاسفل، ولكن في مواقع الدردشه تكون المحاذاة من الأسفل، إي تكون أخر رساله محاذيه لأسفل الحاويه ولإظهار الرسال التي قبلها تقوم بالتمرير للاعلى صعودا، كيف يمكن عمل هذا، نعم في حاجه اسمها السكرول ولكن هذه تنفع للجسم الصفحه اي منطقة body فقط، فكيف لو عندنا حاويات من نوع div منسقه بال css لتكون بحجم معين، السؤال كيف نجعل محاذات النص والعناصر في هذه الحاويه تكون بالاسفل ولاظهار البقيه نصعد للاعلى وشكرا1 نقطة

-

يمكن استخدام خاصية Flex في CSS، حيث يمكنك إضافة التالي لحاوية الرسائل: #MessageList { flex-direction: column-reverse; /* سيتم عكس عرض العناصر داخلها */ } سيتم عرض الأولاد لهذه الحاولة بترتيب من الأسفل للأعلى1 نقطة

-

قمت بحل المشكلة عند طريق تمرير البيانات ( الترجمة ) إلى هذه الصفحة واشتغلت تمام. شكرا1 نقطة

-

يمكن تنفيذ ذلك بعدّة طرق حسب بنية الصفحة لديك وإطار العمل الذي تقوم باستخدامه في كل من الجافاسكريبت و CSS، على سبيل المثال يمكنك إضافة الخاصية resizable الموجودة في jQuery كالتالي: $(function() { $( "img" ).resizable(); }); وربطها مع عنصر الصورة مع وضع التنسيقات اللازمة له، مثل تحديد عرض وارتفاع محددين <img id="resizable" src="your_image_src" height=200px width=200px> كما يمكنك تحديد عرض وطول أعظمي من خلال CSS لعدم تجاوزهم من قبل المستخدم أثناء التعديل. وأيضاً يوجد حل آخر باستخدام CSS3 ولكنه غير مدعوم من قبل جميع المتصفحات: img { resize: both; overflow: auto; } وطبعاً يوجد حلول أخرى في أطر العمل المختلفة ومكاتب إضافية لتنفيذ ذلك.1 نقطة

-

تأكد من تطابق المفتاح الممرر لدالة translate مع ملفات الترجمة، ربما تقوم بتمرير المحتوى بشكل ديناميكي، فتم تمرير متغير فارغ. أو لم يتم الوصول لبيانات الترجمة بالأصل1 نقطة

-

يمكننا مساعدتك بشكل أفضل عندما تذكر تفاصيل أكثر مثل كتابة الكود الذي استخدمته لرفع الصور وأيضاً ماهي المكتبة التي تقوم باستخدامها لمعالجة ذلك وأخيراً الجزء الخاص بتحديد الملفات من واجهة المستخدم. فبما أن رسالة الخطأ هي Cannot read property 'filename' of undefined هذا يعني أنه لا يتم التعرّف على الملف الذي قام المستخدم برفعه ويعود ذلك لعدة أسباب وسأذكر لك بعض النقاط التي قد تساعدك في حل المشكلة: أولاً: يجب عليك التأكد من أنه يتم تحميل الملف وإرساله مع اسم المتغير الصحيح من واجهة المستخدم وتستطيع ذلك من خلال مراقبة المتغيّرات التي يتم إرسالها بالطلب POST من أدوات تطوير المتصفّح لديك أو من خلال استخدام postman. ثانياً: يجب عليك التأكد من أن نوع الترميز الخاص بالـ Form الذي تقوم بإرساله من نوع multipart/form-data: <form method="post" enctype="multipart/form-data" action="/upload"> .... </form> ثالثاً: وبفرض أنك تستخدم المكتبة multer للتعامل مع الملفات في Node JS، يجب عليك التأكد من استخدامها بشكل صحيح كوسيط middleware قبل استقبال القيم إلى المتحكّم الخاص بذلك، وتستطيع الاطلاع عن كيفية تحقيق ذلك من خلال التوثيق لهذه المكتبة أو أي مكتبة تقوم باستخدامها في مشروعك لتحميل الملفات. لأن كل مكتبة لها طريقة تضمين والتعامل معها مختلف.1 نقطة

-

1 نقطة

-

يمكنك استخدام widget Inkwell بحيث تستطيع إسناد حدث الضغط على النص بحيث يمكنك إظهار و إخفاء النص بناء على للقيمة المخزنة في المتغير1 نقطة

-

1 نقطة

-

نفس الفكرة إظهار النص يكون بناء على قيمة value المخزنة.1 نقطة

-

شكرا أخي، لكن لم أقصد هذا، ما قصدته: أن جميع القوائم تكون ظاهرة، عند الضغط على أي واحدة منهم، يظهر النص المخزن تحتها.1 نقطة

-

تقوم بإنشاء متغير فيه قيمة افتراضية لdropdown button مثل String dropdownValue = 'Paragraph 1'; ثم تقوم بإنشاء DropdownButton String dropdownValue = 'Paragraph 1'; @override Widget build(BuildContext context) { return Scaffold( body: Center( child: DropdownButton<String>( value: dropdownValue, onChanged: (String newValue) { setState(() { dropdownValue = newValue; }); }, items: <String>[ 'Paragraph 1', 'Paragraph 2', 'Paragraph 3', 'Paragraph 4' ].map<DropdownMenuItem<String>>((String value) { return DropdownMenuItem<String>( value: value, child: Text(value), ); }).toList(), ), ), ); } ثم تحت هذا DropDownButton تقوم بعرض النص الذي تريده بناء على قيمة dropdownValue التي خزنت فيها. أي تستخدم switch أو if1 نقطة

-

classmethod@ تجعل التابع تابع صنف أي"class method" وبالتالي تمكننا من الوصول إلى الصنف الذي تم فيه تعريف التابع. التابع الذي يتم تعريفه على أنه تابع صف، يستقبل كمعامل أول الصف الخاص به ويعبر عن ذلك ب cls، أي بشكل مشابه لما كنا نفعله في التوابع العادية حينما كنا نمرر للتابع العادي نسخة instance أي (self). إذن هي توابع مرتبطة بالصف وليس بال object. التوابع المعرفة بهذه الطريقة يكون لديها سماحية "access to the state of the class" أي النفاذ إلى حالة الصف (نحن مررنا لها cls أي أنها تشير إلى الصف نفسه وليس نسخة منه) ويمكنها التعديل عليها أيضاً وهذا التعديل ينتقل إلى كل ال object. Static Method@: وهي مشابهة لتلك الموجودة في Java أو C++. الدالة التي نعرفها على أنها ساكة يمكننا الوصول لها من الكلاس نفسه (أي يمكن الوصول لها مباشرة من خلال اسم الكلاس). أو من خلال ال object المأخوذة من الكلاس. عندما يتم إستدعاء التوابع الساكنة من كائن من هذا الكلاس, فإنه لا تتم معاملته بشكل خاص بالنسبة للكائن بل سيبقى كأنك تستدعيها بشكل مباشر من الكلاس. وهذا هو السبب في كونها لاتقبل الوسيط self. التوابع من هذا النوع لاتملك السماحية "access to the state of the class" أي لايمكنها التعديل على حالة الصف. أي أنها لاتعرف شيئ عن حالة الصف class state ولاتستطيع تعديلها أما classmethod يمكنها ذلك. بشكل عام تستخدم class method كنوع من ال factory method (دوال تعيد object (بشكل مشابه لل constructor ) من أجل استخدام معين أنت تريده) أما ال static فتستخدم كأداة للقيام بعمليات معينة. إذا لم يكن لديك معرفة عن factory method يمكنك أن تجدها في هذا المقال: https://wiki.hsoub.com/Design_Patterns/factory_method from datetime import date class Person: def __init__(self, name, age): self.name = name self.age = age # دالة ساكنة لاختبار فيما إذا كان مسناً أم لا @staticmethod def old(age): print("old") return age > 55 #person كلاس ميثود لإنشاء كائن من الصف @classmethod def create(cls, name, year): return cls(name, date.today().year - year) print (Person.old(22)) # True obj=Person.create('km',24) print(obj) # <__main__.Person object at 0x000001C7DC405708> obj.age # 19971 نقطة

-

الحل هو أن داتا التدريب من النمط سترنغ ويجب أن تحولها للصيغة العددية : ['-214' '-153' '-58' ..., '36' '191' '-37'] قم بتحويلها إلى النمط العددي، يمكنك استخدام الطريقة التالية: import numpy as np np.array(['1','2','3']).astype(np.float) هذا الخطأ شائع، لأنه غالباً مايتم تخزين الأعداد على شكل String من أجل فعالية التخزين والحجم.1 نقطة

-

توفر Sklearn القيام بالتوقع الخطي مع التنعيم عن طريق استخدام الكلاس Lasso. يتم استخدامها عبر الموديول linear_model.Lasso كالتالي: sklearn.linear_model.Lasso(alpha=1.0, fit_intercept=True, normalize=False, copy_X=True, max_iter=None, tol=0.001, solver='auto', random_state=None) الوسطاء: fit_intercept: لجعل المستقيم يتقاطع مع أفضل نقطة على المحور العيني y. copy_X: وسيط بولياني، في حال ضبطه على True سوف يأخذ نسخة من البيانات ، وبالتالي لاتتأثر البيانات الأصلية بالتعديل، ويفيدنا في حالة قمنا بعمل Normalize للبيانات. normalize: وسيط بولياني، في حال ضبطه على True سوف يقوم بتوحيد البيانات (تقييسها) اعتماداً على المقياس n_jobs: لتحديد عدد العمليات التي ستتم بالتوازي (Threads) أي لزيادة سرعة التنفيذ، افتراضياُ تكون قيمته None أي بدون تسريع، وبالتالي لزيادة التسريع نضع عدد صحيح وكلما زاد العدد كلما زاد التسريع (التسريع يتناسب مع قدرات جهازك)، وفي حال كان لديك GPU وأردت التدريب عليها فقم بضبطه على -1. random_state: للتحكم بآلية التقسيم. max_iter: العدد الأقصى للتكرارات. tol: مقدار التسماح في التقارب من القيم الدنيا. float, default=1e-3 positive:عندما يأخذ True تكون المعلاملات كلها موجبه أهم ال attributes: _coef: الأوزان التي حصلنا عليها بعد انتهاء التدريب وهي مصفوفة بأبعاد (,عدد الfeatures). intercept: التقاطع مع المحور y. أهم التوابع: fit(data, truevalue): للقيام بعملية التدريب. predict(data): دالة التوقع ونمرر لها البيانات وتعطيك التوقع لها. score(data, truevalue): لمعرفة مدي كفاءة النموذج ونمرر لها بيانات الاختبار والقيم الحقيقية لها فيقوم بعمل predict للداتا الممررة ثم يقارنها بالقيم الحقيقية ويرد الناتج حسي معيار R Squaerd. يمكن تطبيقه كما يلي: from sklearn.datasets import load_boston from sklearn.model_selection import train_test_split from sklearn.linear_model import Lasso # تحميل الداتا BostonData = load_boston() data = BostonData.data labels = BostonData.target # تقسيم البيانات X_train, X_test, y_train, y_test = train_test_split(data, labels, test_size=0.2, shuffle =True, random_state=2021) # تطبيق التابع LassoRegression =Lasso(alpha=0.5,random_state=20,solver='auto') LassoRegression.fit(X_train, y_train) #حساب الكفاءه على التدريب والاختبار print('Train Score is : ' , LassoRegression.score(X_train, y_train)) print('Test Score is : ' , LassoRegression.score(X_test, y_test)) #print('Coef is : ' , LassoRegression.coef_) print(LassoRegression.predict(X_test))1 نقطة

-

SVR هو جزء من موديل support vector machine ويستخدم في مهام التوقع يمكنك استخدامها عبر الموديول sklearn.svm مثل أي نموذج في التعلم الآلي يوجد لديه العديد من المعاملات التي تلعب دوراً أساسيا في عملية تعلم الموديل عبر داتا التدريب لنقوم بالمرور على أهم المعاملات التي يأخذها هذا النموذج. #استدعاء المكتبة: from sklearn.svm import SVR في البداية قمنا باستدعاء المكتبة التي يوجد فيها هذا الموديل #الشكل العام للموديل: SVRModel = SVR(kernel=’rbf’, degree=3, tol=0.001,C=1.0,max_iter=-1,epsilon=0.1,cache_size=200وgamma='auto') أهم البارمتر المستخدمة: البارمتر الأول kernel نوع النواة أو المعادلة المستخدمة تكافئ فكرة تابع التنشيط في الشبكات العصبونية يوجد عدة أنواع ‘linear’, ‘poly’, ‘rbf’, ‘sigmoid’, ‘precomputed’ ننصح دوما باستخدام rbf لأنها الأفضل. البارمتر الثاني degree وهو في حال أردنا جعل ال regressor غير خطي أي Polynomial نضبطه بالدرجة التي نريدها(default=3). بحال استخدام الkernel=poly فيجب تحديد درجة كثير الحدود. البارمتر الثالث tol عدد يمثل نقطة إيقاف التعلم بحال تجاوز هذه القيمه فيتوقف svr. البارمتر الرابع C معامل التنعيم أفضل القيم للتجريب 0.1,0.001,10,1 البارمتر الخامس max_iter العدد الأقصى للتكرارت إذا وضعت -1 فأنه يأخذ الحد الأعلى ويفضل ذلك epsilon: ضمن هذا المقدار لن يتم تطبيق أي penalty على تابع التكلفة. أي هي هامش للسماحية بدون تطبيق penalty. افتراضياً default=0.1. cache_size: تحديد حجم ال kernel cache وافتراضياً 200 MB. gamma: معمل النواة وهي إما {‘scale’, ‘auto’}أو float وتكون افتراضياً 'default=’scale. طبعا قمت بشرح الشكل العام للموديل ولكن عن طريقة استخدامه سهل جداً فقط بعد أن تقوم بتقسيم الداتا إلى X_train, y_train,X_test,. y_test تسطيع كتابة الأتي لعملية التدريب: SVRM = SVR(kernel=’rbf’, degree=3, tol=0.001,C=1.0,max_iter=-1) SVRM.fit(X_train, y_train) حيث الدالة fit يوجد ضمنها جميع العمليات الداخلية لعملية التدريب يوجد دالة أخرى تستخدم لغرض التنبؤ كالاتي. #حساب القيم المتوقعة: y_pred = SVRM.predict(X_test) حيث قمنا بالتنبؤ بقيم التصنيف لداتا الاختبار نستطيع حساب دقة الموديل أو كفاءته على التدريب والاختبار عن طريق التابع score ويكون وفق الشكل #حساب الكفاءه على التدريب والاختبار: print('Train Score is : ' , SVRM.score(X_train, y_train)) print('Test Score is : ' , SVRM.score(X_test, y_test)) مثال: from sklearn.datasets import load_boston from sklearn.model_selection import train_test_split from sklearn.svm import SVR # تحميل الداتا BostonData = load_boston() data = BostonData.data labels = BostonData.target # تقسيم البيانات X_train, X_test, y_train, y_test = train_test_split(data, labels, test_size=0.2, shuffle =True, random_state=44) # تطبيق التابع SVRM = SVR(C = 1.0 ,epsilon=0.1,kernel = 'rbf') SVRM.fit(X_train, y_train) # عرض النتائج print('SVRM Train Score is : ' , SVRM.score(X_train, y_train)) print('SVRM Test Score is : ' , SVRM.score(X_test, y_test))1 نقطة

-

هنا الخطا رسالة التحذير يجب انت تخرج اذا كان الرقم اصغر من 1 واكبر من 991 نقطة

-

لاحظ أني قمت بإستخدام && في الشرط، وإن قمت بإستخدام || بدلًا من && فسيتحقق الشرط دائمًا بما أن الرقم أكبر من صفر لذلك قمت بجعل الشرط كالتالي: // لاحظ تم إستعمال && وليس || لكي يكون الرقم أكبر من 0 وأصغر من 100 if (clinicNumber.value > 0 && clinicNumber.value < 100) { alert('يجب أن يكون رقم العيادة أكبر من 0 وأقل من 100'); } بهذا الشكل سوف يتم تنفيذ الشرط إن كان الرقم ما بين 0 و 100 فقط.1 نقطة

-

شكرا اخي الكريم الكود فيه خطا جرب برقم 150 يبدوا حتى انا اخطات الكود الصحيح ان شاء الله if (clinicNumber.value < 1 || clinicNumber.value > 99) { alert('يجب أن يكون رقم العيادة أكبر من 0 وأقل من 100'); } لاحظ يجب ان يكون الرقم اقل من 100 واكبر من 0 اي من 1 الى 991 نقطة

-

شكرًا لك @ابوسعيد يعقوب على ملاحظتك، لم أنتبه للخطأ الأول، وقمت بإصلاحه. لكن أعتقد أن الأمر الثاني (الخاص بـ clinicNumber) صحيح، حيث أن المطلوب أن يكون الرقم أكبر من صفر وأصغر من 100 تحياتي.1 نقطة

-

يوجد بعض الاخطاء البسيطة if (nationalId.value[0] != "0" || nationalId.value[0] != "1") { alert('يجب أن يبدأ الرقم الوطني بـ 0 أو 1'); } || بدل && وايضا if (clinicNumber.value < 0 || clinicNumber.value > 99) { alert('يجب أن يكون رقم العيادة أكبر من 0 وأقل من 100'); } شكرا1 نقطة

-

يمكن تحديد كل عنصر input من خلال التابع querySelector وتمرير محدد CSS إليه لتحديد كل عنصر input الذي نريده كالتالي: let name = document.querySelector('#name'); let nickname = document.querySelector('#nickname'); let nationalID = document.querySelector('#nationalID'); let clinicNumber = document.querySelector('#clinicNumber'); let address = document.querySelector('#address'); ثم يمكننا الحصول على محتوى كل عنصر من هذه العناصر عن طريق التابع value، بعد ذلك يمكن التحقق من هذه القيمة عن طريقة جملة if else if (name.value == "") { alert('يجب إدخال اسم'); } if (nickname.value == "") { alert('يجب إدخال اسم شهرة'); } if (nationalId.value.length != 11) { alert('يجب أن يكون الرقم الوطني 11 رقم'); } if (nationalId.value[0] != "0" || nationalId.value[0] != "1") { alert('يجب أن يبدأ الرقم الوطني بـ 0 أو 1'); } if (clinicNumber.value > 0 && clinicNumber.value < 100) { alert('يجب أن يكون رقم العيادة أكبر من 0 وأقل من 100'); } أسهل طريقة لعمل هذا الأمر هي إستعمال regular expression كالتالي: format = /^\w+( \w+)*$/ if (! format.test(address)) { alert('يجب أن يتكون العنوان من حروف وأرقام فقط'); } يمكن وضع كل جمل if هذه في حدث submit عند إرسال النموذج ليتم التحقق منها في كل مرة يضغط المستخدم على زر إرسال/حفظ.1 نقطة

-

بتستخدم اوامر الـ SQL في انشاء الجداول وبتحطها في السكربت اللي بتبرمجه وحيشتغل معاك زي مثلا الكود ده CREATE TABLE IF NOT EXISTS `admins` ( `id` INT(255) NOT NULL AUTO_INCREMENT, `pass` VARCHAR (255) NOT NULL, `email` VARCHAR (255) NOT NULL, PRIMARY KEY (`id`) ) Engine=InnoDB; الكود ده حيعملك جدول فيه الـ id , pass , email وحيعمل عمود الـ id يكون primary key بأختصار شديد لازم تكتب اكواد الـ SQL الخاصة بانشاء الجداول1 نقطة

-

لقد نسيت تحديد نوع الرد response الخاص بالملف (responseType) من نمط blob. ولذلك قد يظهر الملف بشكل معطوب أو لا يتم تحميله نهائياً. لحل المشكلة يمكن تعديل الكود لديك وإضافة التالي: const options = { method: 'POST', responseType: 'blob', <=== ضرورية عند التعامل مع الملفات data: formData, url: '/your_api_link', }; return myAPI.request(options);1 نقطة

-

عادة عند تخزين الملفات في السيرفر يكونون في مجلد مثلا storage واذا كان السيرفر مثلا يشتغل على https://website.com سيكون رابط التحميل https:/website.com/storage/file.xlsx في الclient يمكن استخدام العنصر a للتحميل باستعمال الرابط <a target="_blank" rel="noreferrer" href="https://website.com/storage/file.xlsx" > تحميل </a>1 نقطة

-

@Mohamed Salem Gad جزاك الله خيرا @أميمة الزبير جزاكم الله خيرا1 نقطة

-

أنت تحتاج إلى حضور دورة تدريبية فى تحسين محركات البحث (SEO). أو يمكنك توظيف متخصص فى تحسين محركات البحث للعمل علي تهيئة محركات البحث الخاصه بمدونتك.1 نقطة

-

1 نقطة

-

1 نقطة

-

يجب أن يتميز رائد الأعمال بالصفات الأتيه: 1-الثقه بالنفس 2-القدره علي الإقناع 3- الإستمتاع بما يقوم به من أعمال 4- أخلاق الريادة والمهنة 5- الثبات في العمل 6- الاستباقية 7- الإبداع 8- القيادة 9- الصبر 10- الطموح1 نقطة

-

رائد الأعمال هو من يعمل على إقامة نوع مميز وجديد غير مسبوق القيام بمثله، أو الذي يعمل على تطوير منشأة واستغلال كافة الفرص لتطوير هذه المنشأه والتقدم بها. ويتميز رائد الأعمال بالصفات الأتيه: 1-الثقه بالنفس 2-القدره علي الإقناع 3- الإستمتاع بما يقوم به من أعمال 4- أخلاق الريادة والمهنة 5- الثبات في العمل 6- الاستباقية 7- الإبداع 8- القيادة 9- الصبر 10- الطموح وأيضا رائد الأعمال لديه مسئوليه مجتمعيه تجاه وطنه وأهل وطنه بإختصار: رائد الأعمال هو طلعت حرب1 نقطة