-

المساهمات

20 -

تاريخ الانضمام

-

تاريخ آخر زيارة

آخر الزوار

170 زيارة للملف الشخصي

إنجازات Ouis Alhetar

عضو مساهم (2/3)

18

السمعة بالموقع

-

- 6 اجابة

-

- 1

-

-

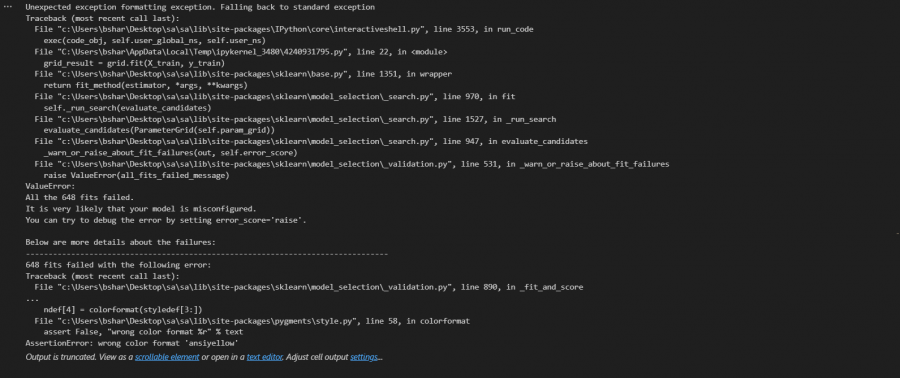

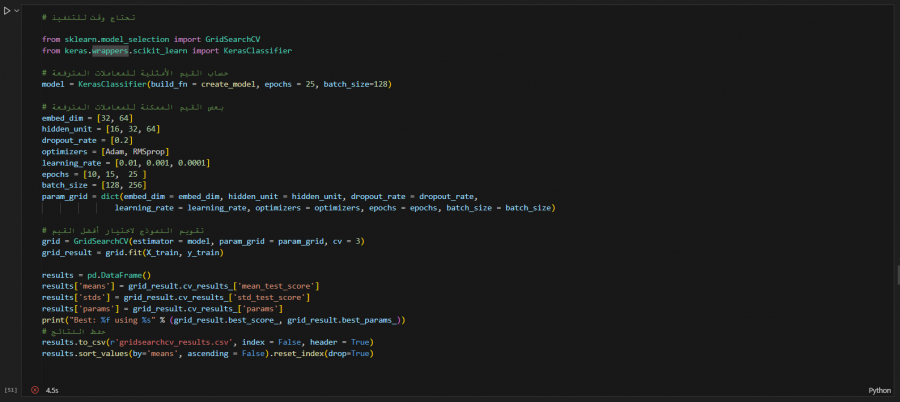

في مشروع تحليل المشاعر في النصوص العربية الموجود في كتاب ١٠ مشاريع عملية في الذكاء الإصطناعي الصادر عن أكاديمية حاسوب وفي أحد الخلايا ظهرت لي هذه المشكلة: وهذا هو الكود الخاص بها: نص الكود: # تحتاج وقت للتنفيذ from sklearn.model_selection import GridSearchCV from keras.wrappers.scikit_learn import KerasClassifier # حساب القيم الأمثلية للمعاملات المترفعة model = KerasClassifier(build_fn = create_model, epochs = 25, batch_size=128) # بعص القيم الممكنة للمعاملات المترفعة embed_dim = [32, 64] hidden_unit = [16, 32, 64] dropout_rate = [0.2] optimizers = [Adam, RMSprop] learning_rate = [0.01, 0.001, 0.0001] epochs = [10, 15, 25 ] batch_size = [128, 256] param_grid = dict(embed_dim = embed_dim, hidden_unit = hidden_unit, dropout_rate = dropout_rate, learning_rate = learning_rate, optimizers = optimizers, epochs = epochs, batch_size = batch_size) # تقويم النموذج لاختيار أفضل القيم grid = GridSearchCV(estimator = model, param_grid = param_grid, cv = 3) grid_result = grid.fit(X_train, y_train) results = pd.DataFrame() results['means'] = grid_result.cv_results_['mean_test_score'] results['stds'] = grid_result.cv_results_['std_test_score'] results['params'] = grid_result.cv_results_['params'] print("Best: %f using %s" % (grid_result.best_score_, grid_result.best_params_)) # حفظ النتائج results.to_csv(r'gridsearchcv_results.csv', index = False, header = True) results.sort_values(by='means', ascending = False).reset_index(drop=True) وهذه هي المكتبات المحملة لدي: Package Version ---------------------------- --------------- absl-py 2.1.0 anyio 4.2.0 arabic-reshaper 3.0.0 argon2-cffi 23.1.0 argon2-cffi-bindings 21.2.0 arrow 1.3.0 asttokens 2.4.1 astunparse 1.6.3 async-lru 2.0.4 attrs 23.2.0 Babel 2.14.0 beautifulsoup4 4.12.3 bleach 6.1.0 cachetools 5.3.2 certifi 2024.2.2 cffi 1.16.0 charset-normalizer 3.3.2 click 8.1.7 colorama 0.4.6 comm 0.2.1 contourpy 1.2.0 cycler 0.12.1 debugpy 1.8.0 decorator 5.1.1 defusedxml 0.7.1 dm-tree 0.1.8 exceptiongroup 1.2.0 executing 2.0.1 fastjsonschema 2.19.1 flatbuffers 23.5.26 fonttools 4.47.2 fqdn 1.5.1 gast 0.5.4 glcontext 2.5.0 google-auth 2.27.0 google-auth-oauthlib 1.2.0 google-pasta 0.2.0 grpcio 1.60.1 h5py 3.10.0 idna 3.6 ipykernel 6.29.0 ipython 8.21.0 ipywidgets 8.1.1 isoduration 20.11.0 jedi 0.19.1 Jinja2 3.1.3 joblib 1.3.2 json5 0.9.14 jsonpointer 2.4 jsonschema 4.21.1 jsonschema-specifications 2023.12.1 jupyter 1.0.0 jupyter_client 8.6.0 jupyter-console 6.6.3 jupyter_core 5.7.1 jupyter-events 0.9.0 jupyter-lsp 2.2.2 jupyter_server 2.12.5 jupyter_server_terminals 0.5.2 jupyterlab 4.0.12 jupyterlab_pygments 0.3.0 jupyterlab_server 2.25.2 jupyterlab-widgets 3.0.9 keras 2.15.0 Keras-Preprocessing 1.1.2 kiwisolver 1.4.5 libclang 16.0.6 Markdown 3.5.2 markdown-it-py 3.0.0 MarkupSafe 2.1.5 matplotlib 3.8.2 matplotlib-inline 0.1.6 mdurl 0.1.2 metrics 0.3.3 mistune 3.0.2 ml-dtypes 0.2.0 mlxtend 0.23.1 moderngl 5.10.0 moderngl-window 2.4.5 multipledispatch 1.0.0 namex 0.0.7 nbclient 0.9.0 nbconvert 7.14.2 nbformat 5.9.2 nest-asyncio 1.6.0 nltk 3.8.1 notebook 7.0.7 notebook_shim 0.2.3 numpy 1.26.3 oauthlib 3.2.2 opt-einsum 3.3.0 overrides 7.7.0 packaging 23.2 pandas 2.2.0 pandocfilters 1.5.1 parso 0.8.3 pathlib2 2.3.7.post1 pathspec 0.5.5 Pillow 10.0.1 pip 23.3.2 platformdirs 4.2.0 prometheus-client 0.19.0 prompt-toolkit 3.0.43 protobuf 4.23.4 psutil 5.9.8 pure-eval 0.2.2 pyasn1 0.5.1 pyasn1-modules 0.3.0 pycparser 2.21 pyglet 2.0.10 Pygments 2.17.2 pyparsing 3.1.1 PyQt5 5.15.10 PyQt5-Qt5 5.15.2 PyQt5-sip 12.13.0 pyrr 0.10.3 python-bidi 0.4.2 python-dateutil 2.8.2 python-json-logger 2.0.7 pytz 2024.1 pywin32 306 pywinpty 2.0.12 PyYAML 6.0.1 pyzmq 25.1.2 qtconsole 5.5.1 QtPy 2.4.1 referencing 0.33.0 regex 2023.12.25 requests 2.31.0 requests-oauthlib 1.3.1 rfc3339-validator 0.1.4 rfc3986-validator 0.1.1 rich 13.7.0 rpds-py 0.17.1 rsa 4.9 scikit-learn 1.4.0 scipy 1.12.0 seaborn 0.13.2 Send2Trash 1.8.2 setuptools 58.1.0 six 1.16.0 sniffio 1.3.0 snowballstemmer 2.2.0 soupsieve 2.5 stack-data 0.6.3 tensorboard 2.15.1 tensorboard-data-server 0.7.2 tensorboard-plugin-wit 1.8.1 tensorflow 2.15.0 tensorflow-estimator 2.15.0 tensorflow-intel 2.15.0 tensorflow-io-gcs-filesystem 0.31.0 termcolor 2.4.0 terminado 0.18.0 threadpoolctl 3.2.0 tinycss2 1.2.1 tomli 2.0.1 tornado 6.4 tqdm 4.66.1 traitlets 5.14.1 types-python-dateutil 2.8.19.20240106 typing_extensions 4.9.0 tzdata 2023.4 uri-template 1.3.0 urllib3 2.2.0 wcwidth 0.2.13 webcolors 1.13 webencodings 0.5.1 websocket-client 1.7.0 Werkzeug 3.0.1 wheel 0.42.0 widgetsnbextension 4.0.9 wordcloud 1.9.3 wrapt 1.14.1 @Mustafa Suleiman @Hikmat Jaafer @حمزة عباد

- 6 اجابة

-

- 1

-

-

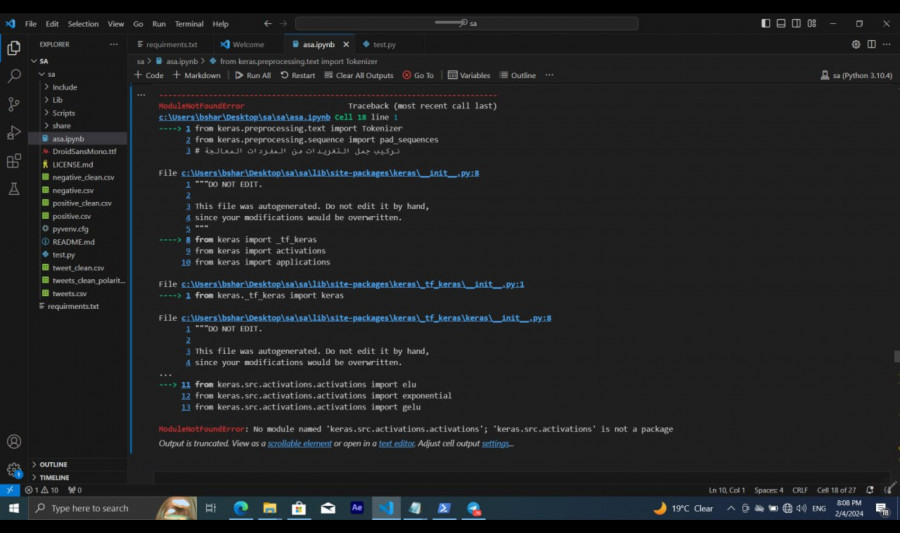

في مشروع تحليل المشاعر في النصوص العربية الموجود في كتاب عشرة مشاريع عملية في الذكاء الاصطناعي الخاص بالأكاديمة وفي إحدى خلايا المشروع ظهرت لي مشكلة التالية : وهذا هو الكود : from keras.preprocessing.text import Tokenizer from keras.preprocessing.sequence import pad_sequences # نركيب جمل التغريدات من المفردات المعالجة sentences = tweets['tweet_preprocessed'].apply(toSentence) print(sentences.values[25]) max_words = 5000 max_len = 50 # التصريح عن المجزئ # مع تحديد عدد الكلمات التي ستبقى # بالاعتماد على تواترها tokenizer = Tokenizer(num_words = max_words ) # ملائمة المجزئ لنصوص التغريدات tokenizer.fit_on_texts(sentences.values) # تحويل النص إلى قائمة من الأرقام S = tokenizer.texts_to_sequences(sentences.values) print(S[0]) # توحيد أطوال الأشعة X = pad_sequences(S, maxlen=max_len) print(X[0]) X.shape مع العلم أني قمت بتثبيت ال keras ولا أدري لماذا يظهر ان المكتبة ليست موجودة

- 1 جواب

-

- 1

-

-

والله كل الشكر.... بس ولو ازعجتك استاذ @حمزة عباد ،،،،،، من أجل تثبيت نسخة أقدم من بايثون بدون الاضرار بالنسخة الحالية فهل أستخدم دوكر مثلا ؟؟ واذا أمكن استخدام دوكر فكيف أربط هذه النسخة بالــ vs code ( وأنوه بأني استطيع تحميل الـ image في دوكر وتشغيلها ولكن لا أدري كيف اشغلها في vs code )

- 7 اجابة

-

- 1

-

-

وماذا يفعل هذا ؟؟؟ لقد حملته وثبته وعرفت انه الاصدار الاخير من ال .net وللمعلومية الاصدار السابق كان مثبت لدي من قبل وكل التقدير لجهودك استاذنا.

-

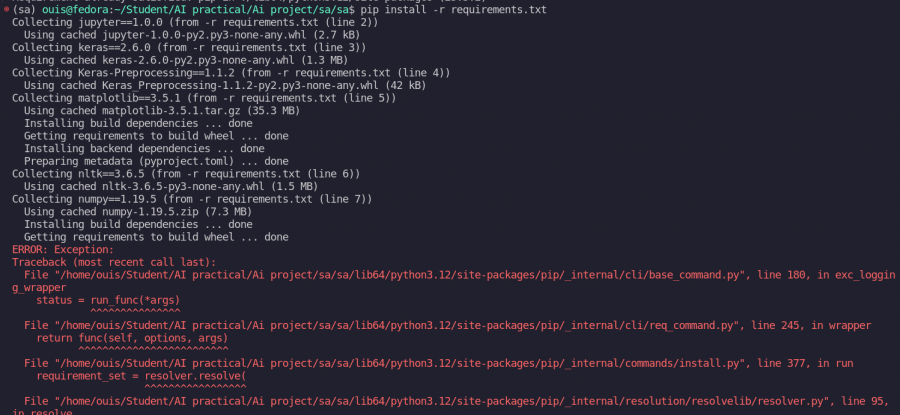

حاولت كل الطرق التي ذكرتها ووصلت للأخيرة(تتغير اصدار ال numpy) وظهر لي التالي: استاذ @Mustafa Suleiman ماذا اذا قمت بتثبيت مكتبة ال numpy بشكل منفصل بحيث لا أحدد الاصدار وثم أحذفها من الملف النصي requirements.txt ؟؟ هل هذا مسوح به ؟

-

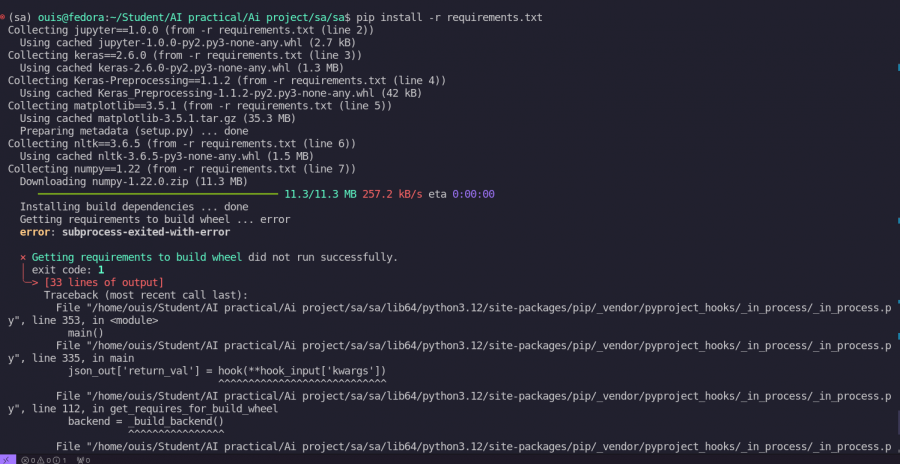

السلام عليكم.. بينما كنت أطبق احد مشاريع الذكاء الاصطناعي الموجودة في كتاب عشرة مشاريع عشرة-مشاريع-عملية-عن-الذكاء-الاصطناعي-أكاديمية-حسوب وبالتحديد مشروع تحليل المشاعر في النصوص العربية حيث وبدأ بانشاء مجلد للمشروع باسم sa وبداخله نفذنا أمر انشاء بيئة : python -m venv sa ثم ولأنني استخدم لينكس فقد استخدمت الامر التالي لتفعيل البيئة بحسب ما ذكره الكتاب: source sa/bin/activate ثم أنشأت ملف اسمه requirements.txt وبداخله وضعت التالي: jupyter==1.0.0 keras==2.6.0 Keras-Preprocessing==1.1.2 matplotlib==3.5.1 nltk==3.6.5 numpy==1.19.5 pandas==1.3.5 scikit-learn==1.0.1 seaborn==0.11.2 sklearn==0.0 snowballstemmer==2.2.0 tensorflow==2.6.0 wordcloud==1.8.1 python-bidi==0.4.2 arabic-reshaper==2.1.3 ثم اغلقت الملف ونفذت السطر التالي لتحميل المكتبات والاعتماديات السابقة: pip install -r requirements.txt وثم ظهر التالي: والذي لاحظته انه يقوم بتحميل اول 5 مكتبات تقريبا (اي يصل الى مكتبة numpy ومن ثم يظهر الخطا) وهذا نص الخطأ كاملا: (sa) ouis@fedora:~/Student/AI practical/Ai project/sa/sa$ pip install -r requirements.txt Collecting jupyter==1.0.0 (from -r requirements.txt (line 2)) Using cached jupyter-1.0.0-py2.py3-none-any.whl (2.7 kB) Collecting keras==2.6.0 (from -r requirements.txt (line 3)) Using cached keras-2.6.0-py2.py3-none-any.whl (1.3 MB) Collecting Keras-Preprocessing==1.1.2 (from -r requirements.txt (line 4)) Using cached Keras_Preprocessing-1.1.2-py2.py3-none-any.whl (42 kB) Collecting matplotlib==3.5.1 (from -r requirements.txt (line 5)) Using cached matplotlib-3.5.1.tar.gz (35.3 MB) Installing build dependencies ... done Getting requirements to build wheel ... done Installing backend dependencies ... done Preparing metadata (pyproject.toml) ... done Collecting nltk==3.6.5 (from -r requirements.txt (line 6)) Using cached nltk-3.6.5-py3-none-any.whl (1.5 MB) Collecting numpy==1.19.5 (from -r requirements.txt (line 7)) Using cached numpy-1.19.5.zip (7.3 MB) Installing build dependencies ... done Getting requirements to build wheel ... done ERROR: Exception: Traceback (most recent call last): File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/cli/base_command.py", line 180, in exc_logging_wrapper status = run_func(*args) ^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/cli/req_command.py", line 245, in wrapper return func(self, options, args) ^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/commands/install.py", line 377, in run requirement_set = resolver.resolve( ^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/resolver.py", line 95, in resolve result = self._result = resolver.resolve( ^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_vendor/resolvelib/resolvers.py", line 546, in resolve state = resolution.resolve(requirements, max_rounds=max_rounds) ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_vendor/resolvelib/resolvers.py", line 397, in resolve self._add_to_criteria(self.state.criteria, r, parent=None) File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_vendor/resolvelib/resolvers.py", line 173, in _add_to_criteria if not criterion.candidates: ^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_vendor/resolvelib/structs.py", line 156, in __bool__ return bool(self._sequence) ^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/found_candidates.py", line 155, in __bool__ return any(self) ^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/found_candidates.py", line 143, in <genexpr> return (c for c in iterator if id(c) not in self._incompatible_ids) ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/found_candidates.py", line 47, in _iter_built candidate = func() ^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/factory.py", line 182, in _make_candidate_from_link base: Optional[BaseCandidate] = self._make_base_candidate_from_link( ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/factory.py", line 228, in _make_base_candidate_from_link self._link_candidate_cache[link] = LinkCandidate( ^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/candidates.py", line 293, in __init__ super().__init__( File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/candidates.py", line 156, in __init__ self.dist = self._prepare() ^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/candidates.py", line 225, in _prepare dist = self._prepare_distribution() ^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/resolution/resolvelib/candidates.py", line 304, in _prepare_distribution return preparer.prepare_linked_requirement(self._ireq, parallel_builds=True) ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/operations/prepare.py", line 525, in prepare_linked_requirement return self._prepare_linked_requirement(req, parallel_builds) ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/operations/prepare.py", line 640, in _prepare_linked_requirement dist = _get_prepared_distribution( ^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/operations/prepare.py", line 71, in _get_prepared_distribution abstract_dist.prepare_distribution_metadata( File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/distributions/sdist.py", line 54, in prepare_distribution_metadata self._install_build_reqs(finder) File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/distributions/sdist.py", line 124, in _install_build_reqs build_reqs = self._get_build_requires_wheel() ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/distributions/sdist.py", line 101, in _get_build_requires_wheel return backend.get_requires_for_build_wheel() ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_internal/utils/misc.py", line 751, in get_requires_for_build_wheel return super().get_requires_for_build_wheel(config_settings=cs) ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_vendor/pyproject_hooks/_impl.py", line 166, in get_requires_for_build_wheel return self._call_hook('get_requires_for_build_wheel', { ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_vendor/pyproject_hooks/_impl.py", line 321, in _call_hook raise BackendUnavailable(data.get('traceback', '')) pip._vendor.pyproject_hooks._impl.BackendUnavailable: Traceback (most recent call last): File "/home/ouis/Student/AI practical/Ai project/sa/sa/lib64/python3.12/site-packages/pip/_vendor/pyproject_hooks/_in_process/_in_process.py", line 77, in _build_backend obj = import_module(mod_path) ^^^^^^^^^^^^^^^^^^^^^^^ File "/usr/lib64/python3.12/importlib/__init__.py", line 90, in import_module return _bootstrap._gcd_import(name[level:], package, level) ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ File "<frozen importlib._bootstrap>", line 1387, in _gcd_import File "<frozen importlib._bootstrap>", line 1360, in _find_and_load File "<frozen importlib._bootstrap>", line 1310, in _find_and_load_unlocked File "<frozen importlib._bootstrap>", line 488, in _call_with_frames_removed File "<frozen importlib._bootstrap>", line 1387, in _gcd_import File "<frozen importlib._bootstrap>", line 1360, in _find_and_load File "<frozen importlib._bootstrap>", line 1331, in _find_and_load_unlocked File "<frozen importlib._bootstrap>", line 935, in _load_unlocked File "<frozen importlib._bootstrap_external>", line 994, in exec_module File "<frozen importlib._bootstrap>", line 488, in _call_with_frames_removed File "/tmp/pip-build-env-8wa4lfgk/overlay/lib/python3.12/site-packages/setuptools/__init__.py", line 18, in <module> from setuptools.extern.six import PY3, string_types ModuleNotFoundError: No module named 'setuptools.extern.six' وخالص شكري مقدما.

- 7 اجابة

-

- 2

-

-

Ouis Alhetar بدأ بمتابعة الحوسبة السحابية Nginx خوادم 4 آخرين

-

السلام عليكم ورحمة الله وبركاته كنت أريد الاستفسار عن خطوات اضافة بوابة دفع من نوع مدى bay (وهي بطاقة دفع محلية مشهورة في المملكة العربية السعودية ) باستخدام php

- 2 اجابة

-

- 1

-